Nos intelligences artificielles comprennent-elles vraiment notre langage ?

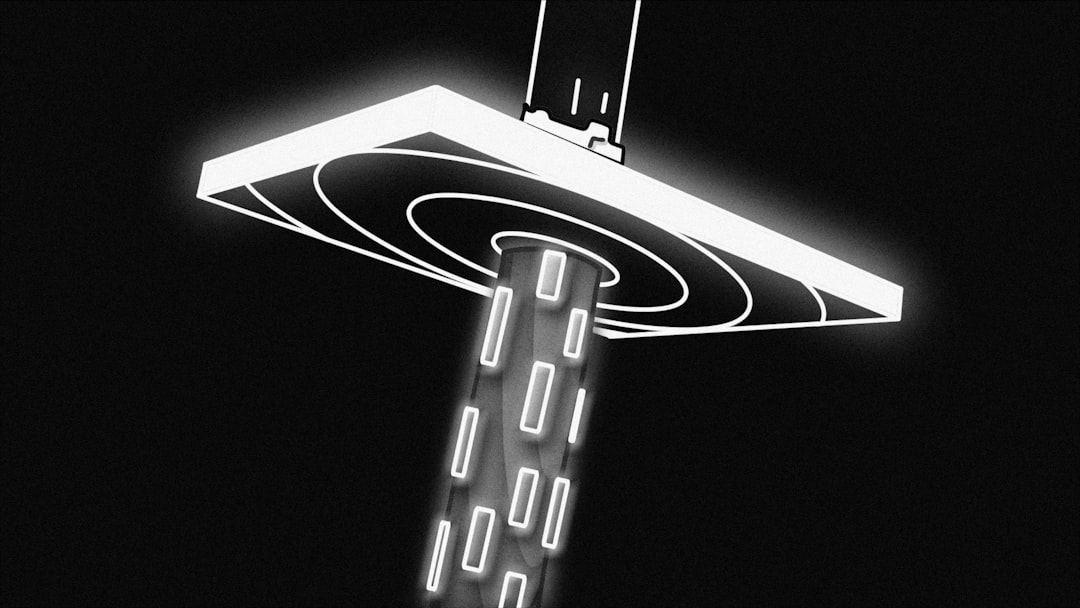

Comment ces modèles, que nous utilisons quotidiennement, traitent-ils le texte qu’on leur donne ? La réponse réside dans une technique appelée la « tokenisation ». Mais qu’est-ce que cela signifie réellement ? Et pourquoi est-ce si crucial pour le fonctionnement des IA génératives comme GPT-4 d’OpenAI ou Gemma ?

Pour simplifier le processus, les modèles transforment le texte en « tokens », des morceaux de texte plus petits. Cela peut aller du mot entier à des syllabes, voire des caractères individuels. Pourquoi cette méthode est-elle incontournable ? Les modèles actuels, basés sur l’architecture des transformateurs, ne peuvent traiter le texte brut sans une puissance de calcul colossale.

La tokenisation améliore la performance, mais à quel prix ?

La méthode de la tokenisation apporte aussi son lot de biais. Ces « tokens » peuvent parfois être traités différemment en fonction de l’espace et de la casse, ce qui peut mener à des comportements inattendus et incompréhensibles pour les humains. Avez-vous déjà remarqué une IA échouer à distinguer « Hello » de « HELLO » ? Le problème vient souvent de la tokenisation.

Mais ce « flou » n’est pas le seul défi. Dans beaucoup de langues autres que l’anglais, les espaces ne séparent pas les mots. Comment les IA gèrent-elles le texte en chinois, japonais, ou encore en thaï ? Mal, apparemment. Une étude d’Oxford en 2023 révèle que pour ces langues, les modèles peuvent prendre jusqu’à deux fois plus de temps pour accomplir une tâche qu’en anglais. Pis, les utilisateurs de ces langues paient plus, car les coûts sont souvent calculés par token. Est-ce juste ?

Les écritures logographiques comme le chinois sont encore plus complexes à tokeniser correctement. Les langues agglutinatives, comme le turc, où chaque petit élément de mot est un token distinct, en sont un autre exemple. Une recherche de Google DeepMind montre que certaines langues nécessitent jusqu’à dix fois plus de tokens pour transmettre le même message qu’en anglais.

Au-delà de ces inégalités linguistiques, la tokenisation pourrait expliquer pourquoi les modèles d’aujourd’hui échouent souvent en mathématiques. Ils fractionnent les chiffres de manière incohérente. Comment un modèle peut-il gérer des équations si « 380 » est un token, mais « 381 » se décompose en « 38 » et « 1 » ? Les modèles se perdent dans les relations entre les chiffres, conduisant à des erreurs absurdes comme penser que 7,735 est supérieur à 7,926.

Peut-on espérer des améliorations sans tokenisation ? Des modèles comme MambaByte, qui traitent les données sous forme de bytes bruts sans passer par la tokenisation, émergent. Cependant, ces recherches sont à leurs débuts. Devons-nous attendre une nouvelle architecture de modèle pour surmonter ces défis ?

En attendant, nous devons reconnaître les limitations actuelles des IA et continuer à explorer de nouvelles voies pour améliorer leur compréhension du langage.

Source : Techcrunch